코세라 (Coursera) 앤드류 응 교수님의 인공지능 강의 1번째 코스, 신경망 및 딥러닝 코스 1주 차 강의 리뷰입니다.

이번 시간에는

로지스틱 회귀(Logistic Regresion) 모델에서 변수 W, b의 값에 따라 달라지는 모델의 정확도를 측정하는,

오차(모델의 정확도)를 측정하는 함수인 비용 함수(Cost function)에 대해 알아봅시다.

이번 강의의 스크립트는 내용이 복잡하고 어려워서,

누구나 이해할 수 있도록 제 방식대로 내용을 요약하여 설명하겠습니다!

이번에도 부분부분 파헤쳐 가며, 강의 내용을 이해해 봅시다.

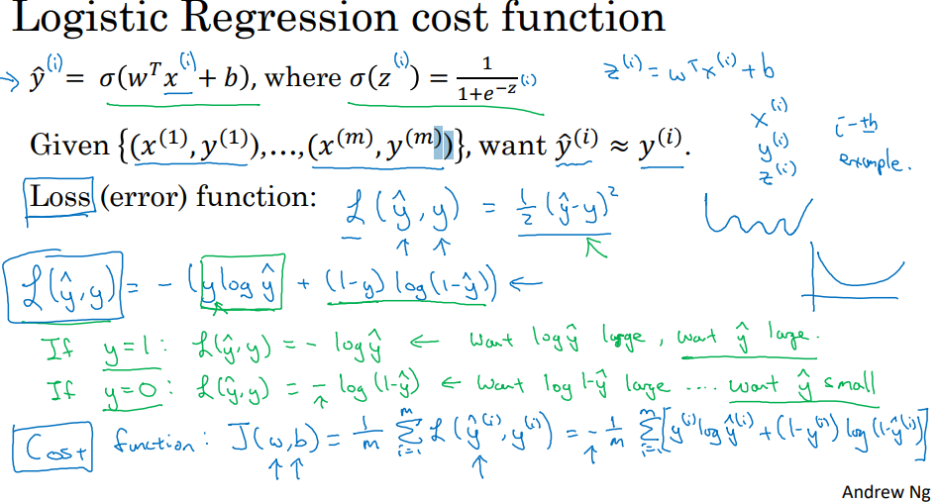

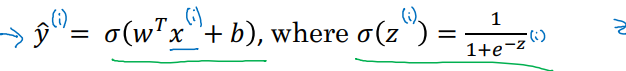

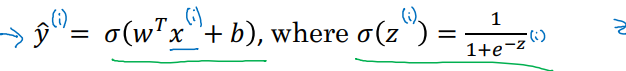

저번 글에서 배웠듯이, y-hat 은 y = 1에 대한 추정치 ( = 기계가 보는 고양이 사진일 확률)이며,

시그모이드 함수(Sigmoid function)에 , Z (W.T*x+b)를 대입한 값이라는 걸 배웠습니다.

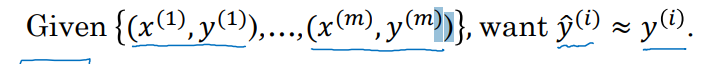

로지스틱 회귀 비용 함수를 통해서, 저희는 y = y-hat이 되기를 원합니다

--> 실제 결과와 기계를 통한 예측이 같아지기를 원한다는 이야기입니다.

위의 그림에서, X, Y는 실제 저희가 기계에게 학습시킬 사진(x)과 그에 대한 정답(y)입니다.

하지만 실제로 예측이 실제 결과와 동일한 경우는 없으므로,

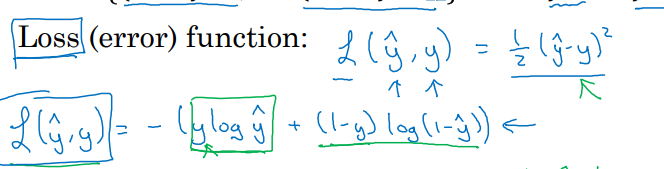

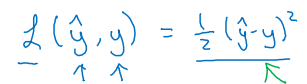

결과와 예측값의 차이인 손실 =오차(loss, error)가 존재하게 됩니다.

x와 y가 m 개 있기에, 그에 따른 손실=오차(loss , error)도 m 개가 나올 것입니다.

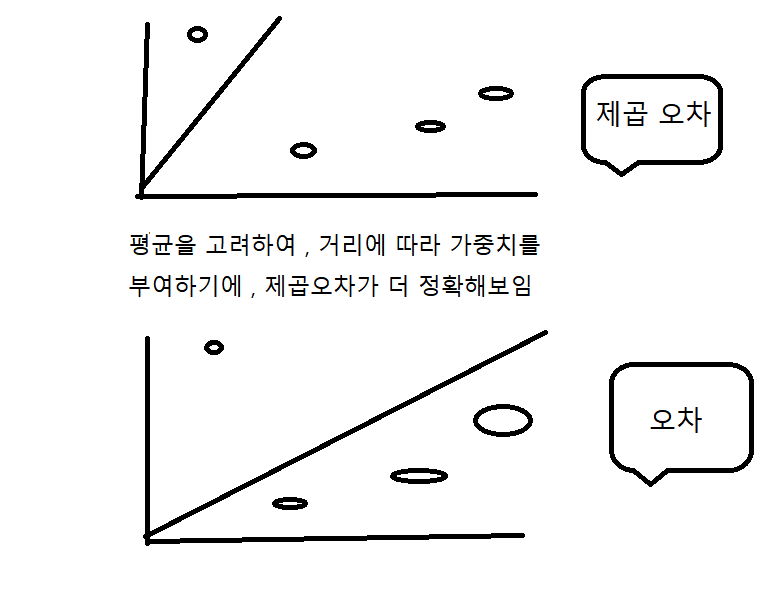

여기서 보통이라면, m 개의 오차들을 제곱하여 최소 하는 방식을 많이 쓰겠지만,

--> 학생 A의 질문 : 왜 오차의 합을 최소화하는 게 아니라, 제곱 오차의 합을 최소화하나요>

답변 : http://https://www.youtube.com/watch? v=3rSecBOH_EQ

링크를 참고해 주세요! 제곱 오차를 최소화해야, 더 정확한 결과를 얻을 수 있기 때문입니다.

아래의 동그라미를 y 값, 그래프를 y-hat이라 하면 아래의 그림 같은 느낌입니다.

y-hat은 시그모이드 함수 값이기 때문에 자연로그 e가 쓰여, 저대로 쓰면 그래프 모양이 이상해집니다.

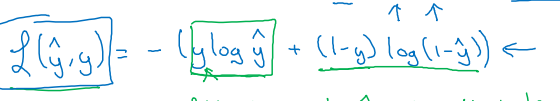

그래서 저희는 비슷한 역할을 하는 로그 손실 함수를 사용하여, 오차를 최소화하겠습니다.

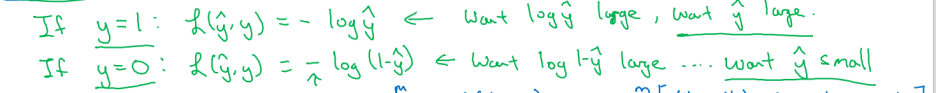

만약 y = 1이라면, 오차(손실) = -log(y-hat) 됩니다.

여기서 오차를 최대한 작게 만들기 위해서는 y-hat이 최대한 커야 합니다.

---> ( y-hat = 0 ~ 1이라서, y가 커야 log(y-hat)이 작 이지기 때문에)

만약 y = 0이라면, 반대로 y-hat이 최대한 작아야 합니다.

--> ( 아래의 그림 참조 y-hat 가 w, b를 매개변수로 사용하기 때문에 )

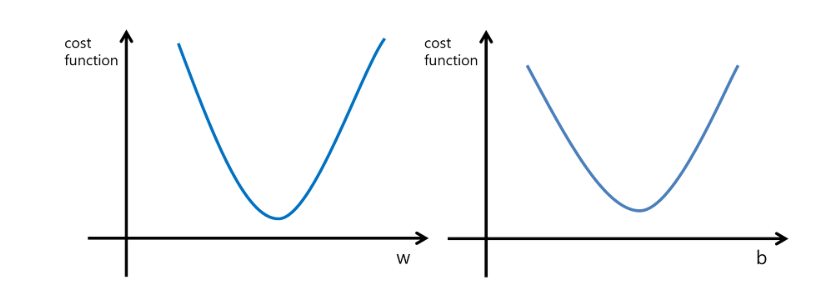

비용 함수(Cost function) J(w, b)는 m 개의 오차의 총합을 다시 m으로 나누어,

오차의 평균치를 구하는 함수입니다.

비용 함수(Cost function)의 모양은 이러한 모양이며 ,

매개변수 W, b를 합쳤기에 , 비용 함수 J(w,b)를 3차 원상으로 표현하게 되면 아래의 모양입니다.

요약정리 :

저희는 실제 정답(결과) ( y) 와 기계가 한 예측 ( y-hat)을 최대한 같게 하려고 합니다.

여기서, 결과와 예측의 차이를 오차 or 손실(loss or error)라고 하며

손실 함수(loss function)는 단일 예제의 오차이고,

비용 함수(Cost function)는 전체 예제의 오차 평균입니다.

학습을 통해서 매개변수 w, b를 수정해가며,

비용 함수 J를 최소화하는 적절한 w, b 값을 구하는 것이 저희의 임무입니다.

다음 시간에는 기울기 하강법(Gradient Descent)에 대해 배워봅시다.

--> 매개 변수 w , b를 적은 시도만으로 적절한 w , b의 값을 찾기 위한 지름길을 탐색하는 방법

이 내용들은 모두 coursera에서 앤드루 응 교수님의 강의를 요약정리 및 쉽게 재 풀이하여 적은 글이며,

내용에는 생략되거나 변형된 부분이 많으니 직접 강의를 들어보시는 걸 추천드립니다!

이 글은 상업적 목적이 아닌, 한국에서 인공지능을 배우고 싶은 분들을 위해 적은 교육적 목적에서 작성하였습니다.

'코세라 앤드류 응 AI 강의 리뷰' 카테고리의 다른 글

| [인공지능 강의 리뷰] 8 - 로지스틱 회귀 경사 하강법(Logistic Regression Gradient Descent) (0) | 2022.05.16 |

|---|---|

| [인공지능 강의 리뷰] 7 - 도함수(Derivative)와 계산 그래프 (Computation Gragh) (0) | 2022.05.09 |

| [인공지능 강의 리뷰] 6 - 경사 하강법(Gradient Descent) (0) | 2022.05.09 |

| [인공지능 강의 리뷰] 4 - 로지스틱 회귀(Logistic Regression) (0) | 2022.05.02 |

| [인공지능 강의 리뷰] 3 - 이진 분류(Binary Classification) 와 로지스틱 회귀(Logistic Regression) (0) | 2022.05.02 |

| [인공지능 강의 리뷰] 2 - 지도 학습(Supervised Learning with Neural Network) (0) | 2022.04.19 |

| [인공지능 강의 리뷰] 1 - 신경망(Neural Network) (0) | 2022.04.19 |